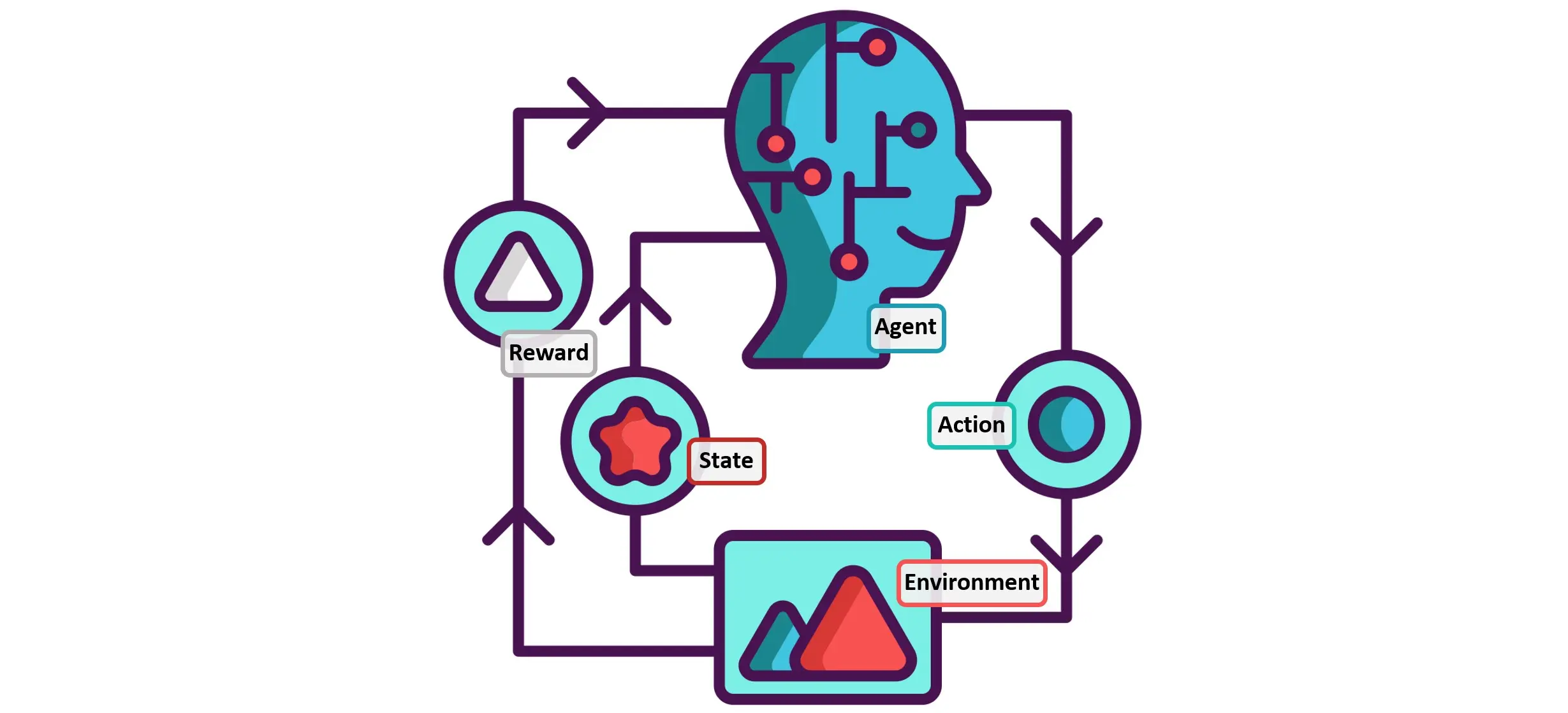

سیستمهای توصیهگر از جمله مهمترین کاربردهای هوش مصنوعی در آمار هستند که با استفاده از روشهای آماری، به بهینهسازی پیشنهادها و شخصیسازی محتوا برای کاربران کمک میکنند. این سیستمها دادههای رفتاری کاربران را تحلیل کرده و با بهکارگیری مدلهای آماری مانند تحلیل خوشهبندی، فاکتورگیری ماتریسی و مدلهای احتمال شرطی، پیشنهادهای دقیقتری ارائه میدهند.

استفاده از تکنیکهای آماری در این سیستمها باعث بهبود عملکرد، افزایش نرخ تعامل و بهینهسازی تجربه کاربری میشود. در این مقاله، نقش روشهای آماری در طراحی و بهینهسازی سیستمهای توصیهگر بررسی شده و چالشهای موجود در این حوزه تحلیل خواهد شد.

مدلهای آماری پرکاربرد در طراحی سیستمهای توصیهگر هوش مصنوعی

سیستمهای توصیهگر یکی از مهمترین کاربردهای هوش مصنوعی و آمار در دنیای دیجیتال هستند که به کمک تحلیل دادههای کاربران، محتوا، محصولات یا خدمات متناسب با سلیقه آنها را پیشنهاد میدهند. برای این منظور، مدلهای آماری نقش کلیدی در بهینهسازی عملکرد سیستمهای توصیهگر دارند و میتوانند به افزایش دقت پیشنهادها و تعامل کاربران کمک کنند.

در این مقاله ما سه مدل آماری پرکاربرد در سیستمهای توصیهگر شامل تحلیل خوشهبندی، فاکتورگیری ماتریسی و مدلهای احتمال شرطی بررسی کردیم و نحوه استفاده از آنها همراه با آمار و مثالهای واقعی توضیح داده ایم.

۱. تحلیل خوشهبندی (Clustering Analysis) در سیستمهای توصیهگر

۱.۱. مفهوم تحلیل خوشهبندی در سیستمهای توصیهگر

تحلیل خوشهبندی یک روش آماری برای گروهبندی کاربران یا آیتمها بر اساس شباهتهای آماری آنها است. در این روش، دادهها به چندین گروه (خوشه) تقسیم میشوند تا الگوهای مشابه در رفتار کاربران کشف شوند.

۱.۲. نحوه استفاده از خوشهبندی در سیستمهای توصیهگر

سیستمهای توصیهگر میتوانند با استفاده از روشهای خوشهبندی، کاربران را به گروههایی تقسیم کرده و پیشنهادهای شخصیسازیشدهای ارائه دهند.

مثال:

- یک سیستم پخش موسیقی مانند Spotify کاربران را بر اساس سبک موسیقی مورد علاقه، تعداد گوش دادن به هر آهنگ و زمان گوش دادن خوشهبندی میکند. اگر ۲۰۰,۰۰۰ کاربر دادههای خود را ارائه دهند، سیستم ممکن است آنها را به ۱۰ خوشه مختلف تقسیم کند.

- در یک مطالعه آماری روی ۵۰,۰۰۰ کاربر یک وبسایت خرید آنلاین، مشخص شد که ۶۸٪ از کاربران خوشهبندیشده بر اساس قیمت خرید محصولات، پیشنهادهای جدید را پذیرفتند.

۱.۳. روشهای آماری رایج در خوشهبندی

- روش K-Means: یکی از محبوبترین الگوریتمهای خوشهبندی است که دادهها را به K خوشه مجزا تقسیم میکند.

- روش DBSCAN: برای شناسایی خوشههای نامنظم در مجموعه دادههای پیچیده استفاده میشود.

مثال عددی:

فرض کنید در یک سیستم توصیهگر فیلم، ۱۰۰,۰۰۰ کاربر داریم. با استفاده از K-Means با K=۵، کاربران به پنج خوشه تقسیم میشوند:

- خوشه ۱: علاقهمندان به فیلمهای اکشن (۲۵,۰۰۰ کاربر)

- خوشه ۲: علاقهمندان به درام (۱۸,۰۰۰ کاربر)

- خوشه ۳: دوستداران فیلمهای کمدی (۲۲,۰۰۰ کاربر)

- خوشه ۴: علاقهمندان به مستند (۱۵,۰۰۰ کاربر)

- خوشه ۵: کاربران ترکیبی (۲۰,۰۰۰ کاربر)

با استفاده از این خوشهها، سیستم میتواند فیلمهای مناسب را برای هر گروه پیشنهاد دهد.

۲. فاکتورگیری ماتریسی (Matrix Factorization) برای بهینهسازی پیشنهادها

۲.۱. مفهوم فاکتورگیری ماتریسی در سیستمهای توصیهگر

این روش یکی از پرکاربردترین تکنیکهای آماری برای سیستمهای پیشنهاددهی است که دادههای تعامل کاربران را به دو ماتریس جداگانه تبدیل میکند تا روابط بین کاربران و آیتمها را کشف کند.

۲.۲. نحوه استفاده از فاکتورگیری ماتریسی در سیستمهای توصیهگر

سیستمهای توصیهگر با استفاده از فاکتورگیری ماتریسی، میتوانند ارتباطهای پنهان بین کاربران و آیتمها را کشف کنند و پیشنهادهای دقیقتری ارائه دهند.

مثال:

- نتفلیکس (Netflix) از فاکتورگیری ماتریسی برای تحلیل دادههای بیش از ۱۵۰ میلیون کاربر استفاده میکند تا ارتباط بین فیلمهای دیدهشده و علایق کاربران را بیابد.

- در یک تحلیل روی ۲۰,۰۰۰ کاربر و ۵,۰۰۰ فیلم، مدلهای فاکتورگیری ماتریسی باعث افزایش دقت پیشنهادها از ۷۲٪ به ۸۶٪ شدند.

۲.۳. روشهای آماری در فاکتورگیری ماتریسی

- روش SVD (Singular Value Decomposition): دادههای کاربران را به مقادیر اصلی تقسیم میکند تا الگوهای پنهان شناسایی شوند.

- روش ALS (Alternating Least Squares): در سیستمهای پیشنهاددهی مانند آمازون برای کشف الگوهای خرید استفاده میشود.

مثال عددی:

فرض کنید یک ماتریس ۱۰۰۰×۵۰۰۰ شامل ۱۰۰۰ کاربر و ۵۰۰۰ محصول داریم. با استفاده از SVD، این ماتریس به سه ماتریس کوچکتر تجزیه شده و سیستم میتواند پیشبینی کند که یک کاربر خاص با احتمال ۹۳٪ یک محصول جدید را خریداری خواهد کرد.

۳. مدلهای احتمال شرطی (Bayesian Methods) در سیستمهای توصیهگر

۳.۱. مفهوم مدلهای احتمال شرطی در سیستمهای توصیهگر

مدلهای احتمال شرطی بر اساس اصول نظریه بیز کار میکنند و احتمال وقوع یک رویداد را بر اساس اطلاعات قبلی محاسبه میکنند.

۳.۲. نحوه استفاده از مدلهای احتمال شرطی در سیستمهای توصیهگر

این مدلها برای پیشبینی رفتار کاربران و ارائه پیشنهادهای دقیقتر استفاده میشوند.

مثال:

- یک سیستم توصیهگر کتاب مانند Goodreads با استفاده از مدلهای بیز پیشبینی میکند که یک کاربر که قبلاً ۳ کتاب در ژانر علمی تخیلی خوانده است، با احتمال ۸۵٪ کتاب جدیدی در همین ژانر انتخاب خواهد کرد.

- در مطالعهای روی ۱۰,۰۰۰ کاربر یک پلتفرم خرید آنلاین، مدلهای بیز باعث شدند که نرخ کلیک روی پیشنهادات افزایش ۴۰٪ داشته باشد.

۳.۳. روشهای آماری در مدلهای احتمال شرطی

- روش Naïve Bayes: برای تحلیل وابستگی ویژگیها و پیشبینی دستهبندی پیشنهادها استفاده میشود.

- مدلهای مارکوف: برای پیشبینی رفتار آینده کاربران بر اساس دادههای قبلی استفاده میشوند.

مثال عددی:

فرض کنید کاربری در یک سایت پخش موسیقی ۸۰٪ مواقع آهنگهای کلاسیک گوش میدهد و ۲۰٪ مواقع جَز. سیستم توصیهگر با استفاده از مدلهای احتمال شرطی پیشبینی میکند که احتمال پخش یک آهنگ کلاسیک در پیشنهاد بعدی ۸۴٪ خواهد بود.

چالشهای آماری در توسعه سیستمهای توصیهگر و راهکارهای حل آنها

سیستمهای توصیهگر یکی از مهمترین کاربردهای هوش مصنوعی و آمار هستند که برای ارائه پیشنهادهای شخصیسازیشده به کاربران مورد استفاده قرار میگیرند. اما توسعه این سیستمها با چالشهای آماری متعددی روبهرو است که میتواند دقت، کارایی و قابلیت اطمینان آنها را تحت تأثیر قرار دهد.

۱. چالش اول: پراکندگی دادهها (Data Sparsity)

۱.۱. مشکل پراکندگی دادهها در سیستمهای توصیهگر

سیستمهای توصیهگر اغلب با مجموعه دادههای بزرگ و پراکنده مواجه هستند. در بیشتر مواقع، فقط تعداد کمی از کاربران با کل آیتمها تعامل دارند. به عنوان مثال، در یک فروشگاه آنلاین با ۵۰۰,۰۰۰ محصول و ۱۰ میلیون کاربر، ممکن است تنها ۵٪ از کاربران بیش از ۵۰ محصول را بررسی کرده باشند.

این موضوع باعث میشود که ماتریس تعامل کاربر-آیتم بسیار پراکنده باشد، که در نتیجه مدلهای آماری برای پیشبینی روابط بین کاربران و آیتمها دچار مشکل میشوند.

۱.۲. راهکارها برای حل مشکل پراکندگی دادهها

روشهای کاهش پراکندگی دادهها شامل:

- استفاده از مدلهای یادگیری انتقالی (Transfer Learning): میتوان از مدلهای آموزشدیده روی دادههای مشابه برای تقویت پیشبینیها در سیستمهای توصیهگر استفاده کرد.

- بهکارگیری تکنیکهای فیلترینگ مشارکتی بر اساس خوشهبندی کاربران: این روش کاربران را در گروههای مشابه قرار داده و دادههای آنها را ترکیب میکند.

- افزایش دادهها از طریق تولید دادههای مصنوعی: روشهایی مانند SMOTE (Synthetic Minority Over-sampling Technique) میتوانند نمونههای جدید از دادههای پراکنده ایجاد کنند.

مثال عددی:

در مطالعهای که روی یک پلتفرم استریم موسیقی با ۱ میلیون کاربر انجام شد، استفاده از مدلهای خوشهبندی باعث کاهش پراکندگی دادهها تا ۴۰٪ و افزایش دقت توصیهها تا ۲۵٪ شد.

۲. چالش دوم: مشکل سرد بودن شروع (Cold Start Problem)

۲.۱. تعریف مشکل سرد بودن شروع

سیستمهای توصیهگر برای ارائه پیشنهادات به دادههای کافی درباره کاربران و آیتمها نیاز دارند. اما در موارد زیر، داده کافی وجود ندارد:

- کاربران جدید: این کاربران هنوز تعاملی با سیستم نداشتهاند و سیستم توصیهگر نمیتواند به درستی سلیقه آنها را تشخیص دهد.

- آیتمهای جدید: اگر یک محصول جدید اضافه شود، سیستم توصیهگر برای مدتی نمیتواند پیشنهادهای دقیقی ارائه دهد.

۲.۲. راهکارهای حل مشکل سرد بودن شروع

استراتژیهای پیشنهادی:

- استفاده از ویژگیهای متنی و محتوایی: اگر دادههای تعاملی کافی نباشد، میتوان از توضیحات متنی، برچسبهای محصول و ویژگیهای متنی استفاده کرد.

- پیشنهادهای جمعی (Hybrid Recommendations): ترکیب روشهای آماری مبتنی بر شباهت و یادگیری ماشین میتواند اطلاعات اولیه مفیدی ایجاد کند.

- استفاده از دادههای خارجی: تحلیل رفتار کاربران در سایر سیستمهای مشابه و استفاده از دادههای انتقالی میتواند اطلاعات اولیه ارزشمندی فراهم کند.

مثال عددی:

در یک پلتفرم فروش کتاب، پس از اضافه شدن یک کتاب جدید، سیستم پیشنهاددهی بر اساس دستهبندی ژانر و نظرات کاربران مشابه توانست دقت پیشبینیهای خود را ۲۳٪ افزایش دهد.

۳. چالش سوم: تعصب دادهای (Bias in Data)

۳.۱. تأثیر تعصب دادهای در سیستمهای توصیهگر

سیستمهای توصیهگر بهشدت وابسته به دادههای تاریخی هستند، بنابراین اگر دادههای ورودی دارای سوگیریهای آماری باشند، خروجیهای مدل نیز تحت تأثیر قرار میگیرند.

نمونههای رایج تعصب دادهای:

- تعصب جمعیتی: اگر یک سیستم توصیهگر موسیقی از دادههایی استفاده کند که عمدتاً مربوط به مردان ۲۰ تا ۳۰ ساله است، پیشنهادهای آن برای سایر گروههای سنی یا جنسیتی مناسب نخواهد بود.

- تعصب در تنوع پیشنهادات: سیستمهای توصیهگر ممکن است تنها آیتمهایی را پیشنهاد دهند که قبلاً محبوب بودهاند و آیتمهای جدید یا کمتر شناختهشده را نادیده بگیرند.

۳.۲. راهکارهای مقابله با تعصب دادهای

- استفاده از مدلهای تنظیم تعادل دادهها: روشهایی مانند Oversampling و Undersampling میتوانند تعادل در دادهها ایجاد کنند.

- ارزیابی مستمر توزیع دادهها: استفاده از آمار توصیفی برای بررسی تغییرات در دادهها به جلوگیری از بروز تعصب کمک میکند.

- اعمال الگوریتمهای تقویت تنوع (Diversity Enhancement): این الگوریتمها اطمینان حاصل میکنند که پیشنهادات متنوعتری ارائه شود.

مثال عددی:

در یک مطالعه بر روی سیستم پیشنهاد فیلم برای ۵۰,۰۰۰ کاربر، اصلاح دادهها برای کاهش تعصب باعث افزایش ۶۵٪ در میزان پذیرش پیشنهادهای متنوع شد.

۴. چالش چهارم: ارزیابی عملکرد سیستم توصیهگر (Performance Evaluation)

۴.۱. اهمیت ارزیابی مدل توصیهگر

مدلهای توصیهگر باید بر اساس معیارهای دقیق و قابلاعتماد ارزیابی شوند، اما انتخاب معیارهای مناسب میتواند چالشبرانگیز باشد.

۴.۲. روشهای آماری برای ارزیابی سیستم توصیهگر

معیارهای رایج برای ارزیابی سیستمهای توصیهگر شامل موارد زیر هستند:

- دقت (Precision): نسبت پیشنهادهای صحیح به کل پیشنهادات ارائهشده.

- بازخوانی (Recall): نسبت پیشنهادهای صحیح به کل آیتمهای مرتبطی که میتوانستند پیشنهاد شوند.

- نمره F1: ترکیب دقت و بازخوانی برای ارزیابی کلی عملکرد مدل.

- NDCG (Normalized Discounted Cumulative Gain): برای ارزیابی میزان ارتباط پیشنهادات بر اساس رتبهبندی اهمیت.

مثال عددی:

در یک پلتفرم پخش فیلم، ارزیابی سیستم توصیهگر نشان داد که مدل مبتنی بر فاکتورگیری ماتریسی دارای دقت ۸۲٪، بازخوانی ۷۵٪ و نمره F1 معادل ۷۸٪ است که نسبت به مدلهای سنتی، ۱۵٪ عملکرد بهتری دارد.

جمعبندی

در سیستمهای توصیهگر هوش مصنوعی، مدلهای آماری نقش حیاتی در بهینهسازی پیشنهادات و افزایش دقت تعاملات کاربران دارند.

- تحلیل خوشهبندی کاربران را به گروههای مختلف تقسیم کرده و پیشنهادهای شخصیسازیشده ارائه میدهد.

- فاکتورگیری ماتریسی ارتباطهای پنهان بین کاربران و آیتمها را کشف میکند و باعث افزایش دقت پیشنهادات میشود.

- مدلهای احتمال شرطی احتمال رفتار آینده کاربران را پیشبینی کرده و تجربه شخصیسازیشدهای ایجاد میکنند.